近年、画像認識AIの性能は飛躍的に向上していますが、その意思決定プロセスは「ブラックボックス」であるとの指摘があります。AIがなぜそのような判断を下したのか、その根拠を説明することは容易ではありません。こうした問題に対するソリューションの1つが、Grad-CAM(Gradient-weighted Class Activation Mapping)と呼ばれる手法です。本記事では、Grad-CAMの基本的な仕組みから最新の研究動向まで、画像認識AIの意思決定を可視化する手法について詳しく解説します。

・Grad-CAMの基本的な仕組みと計算方法

・Grad-CAMを活用することで得られるメリットと意義

・医療や自動運転などの分野におけるGrad-CAMの具体的な応用事例

・Grad-CAM++やSmooth Grad-CAM++などの最新の改良手法

・説明可能AIの実現に向けた、Grad-CAMを超える可視化技術の研究動向

・Grad-CAMの課題と、説明可能AIの今後の展望

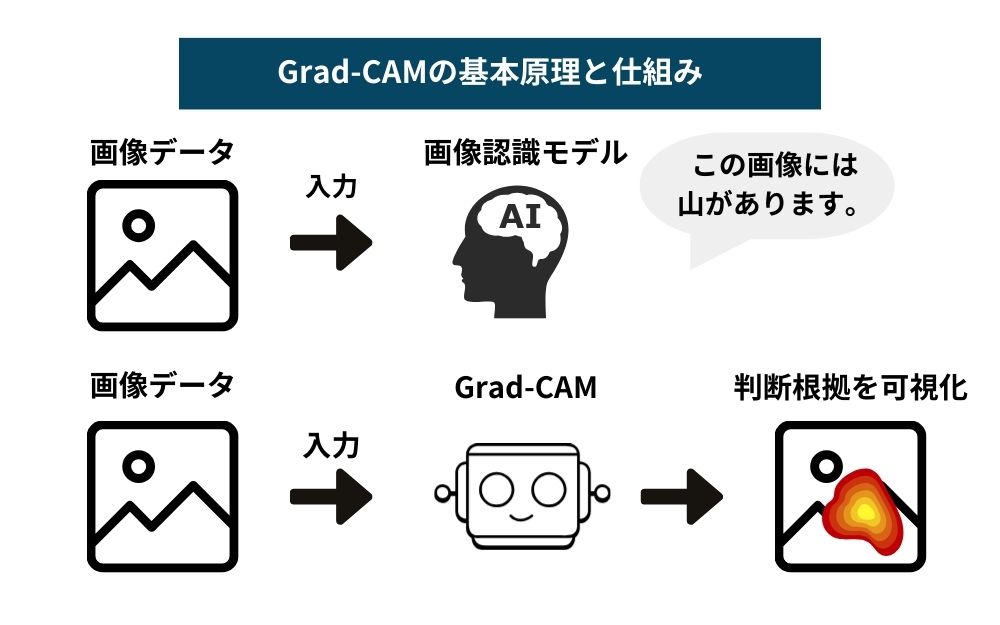

Grad-CAMの基本原理と仕組み

Grad-CAM(Gradient-weighted Class Activation Mapping)は、CNNを用いた画像認識モデルの判断根拠を可視化するための手法です。CNNは画像分類タスクにおいて非常に高い性能を達成していますが、その判断プロセスはブラックボックス的で、なぜそのような判断を下したのかを説明することが困難でした。Grad-CAMは、このブラックボックス問題に対するソリューションの1つとして提案されました。

Grad-CAMは、CNNの中間層の活性化マップに基づいて、画像のどの領域が判断に影響しているかを可視化する手法

Grad-CAMの基本的なアイデアは、CNNの中間層(通常は最終畳み込み層)から得られる特徴マップ(活性化マップ)に着目し、その特徴マップが最終的な分類スコアにどの程度影響を与えているかを計算することです。具体的には、注目するクラスについて、CNNの出力層から中間層の活性化マップへの勾配を計算し、その勾配の平均値を各チャネルの重要度とみなします。そして、その重要度を活性化マップに掛け合わせることで、以下のように入力画像内のどの領域が判断に重要な役割を果たしているかを示すヒートマップを生成します。

Grad-CAMを活用するメリットと意義

Grad-CAMに代表される説明可能AIの手法は、AIの意思決定プロセスに透明性を与え、人間とAIの協調を促進する上で重要な役割を果たします。ここでは、Grad-CAMを活用することで得られるメリットと、その意義について解説します。

AIの判断根拠を「説明」し、意思決定プロセスに透明性を持たせることができる

Grad-CAMを用いることで、AIモデルが画像のどの部分に着目して判断を下したのかを視覚的に示すことができます。これにより、AIの意思決定プロセスに透明性を持たせ、なぜそのような判断を下したのかを人間が理解・解釈しやすくなります。AIの判断根拠を明示することは、AIシステムへの信頼性を高める上で非常に重要です。ユーザーは、AIの予測可能性が向上し、システムをより信頼して活用できるようになります。また、AIの意思決定に説明責任(Accountability)を持たせることもできます。AIの判断が誤っていたり、倫理的に問題がある場合、その原因を特定し、改善につなげることが可能になります。説明可能性は、AIシステムの公平性(Fairness)や安全性(Safety)の向上にも寄与します。偏ったデータによる学習や、意図しない判断基準の獲得を発見し、是正することができるのです。

ユーザーや開発者がAIの挙動を理解・解釈しやすくなり、AIへの信頼性が向上する

Grad-CAMによってAIの判断根拠が可視化されることで、ユーザーはAIの挙動をより深く理解し、解釈することができます。なぜAIがそのような判断を下したのか、その理由が明確になることで、ユーザーのAIに対する信頼性が向上します。AIを活用する際の不安や懸念を軽減し、AIとの協働を円滑に進めることができるでしょう。

また、開発者にとっても、Grad-CAMは大きなメリットをもたらします。モデルの振る舞いを詳細に分析し、問題点を特定することが容易になります。説明可能AIの手法を用いることで、モデルのデバッグやチューニングが効率的に行えるようになるのです。

さらに、異なる分野の専門家とのコミュニケーションも円滑になります。例えば、医療分野でAIを活用する際、AIの判断根拠を医師に説明することで、AIへの理解が深まり、協働が促進されます。専門家の知見とAIの能力を組み合わせることで、より高度で信頼性の高い意思決定が可能になるでしょう。

以上のように、Grad-CAMを活用することで、AIの意思決定プロセスに透明性を持たせ、ユーザーや開発者がAIの挙動を理解・解釈しやすくなります。これにより、AIへの信頼性が向上し、人間とAIの協調が促進されます。説明可能なAIの実現は、AIの社会実装を進める上で不可欠な要素であり、Grad-CAMはその重要な一歩を担っていると言えるでしょう。

Grad-CAMの具体的な活用例と応用方法

Grad-CAMは、様々な分野でAIの判断根拠を可視化し、人間とAIの協働を促進するために活用されています。ここでは、医療と自動運転への応用事例を紹介し、Grad-CAMを自身のプロジェクトに導入するための実装手順とTipsについて解説します。

医療画像診断への応用事例

医療分野では、AIを用いた画像診断が急速に発展しています。しかし、AIの判断根拠が不透明であることが、医療現場での活用を妨げる要因の一つとなっています。Grad-CAMを用いることで、AIが画像のどの部分に着目して診断を下したのかを可視化することができます。

例えば、がんの画像診断において、AIが病変部位を正確に検出できているかを確認することができます。Grad-CAMによって可視化された判断根拠を医師が確認することで、AIの診断を信頼し、最終的な意思決定に役立てることができるでしょう。こうしたAIと医師の協働により、診断精度の向上が期待できます。

自動運転車の画像認識への応用事例

自動運転車は、カメラ画像から歩行者や他の車両を検出し、適切な運転制御を行う必要があります。この画像認識の過程で、AIがどの部分に着目しているかを可視化することは、システムの安全性を評価し、改善する上で重要です。

Grad-CAMを用いることで、AIが歩行者や車両を適切に認識しているか、あるいは誤検出の原因となっている画像の部分を特定することができます。これにより、エンジニアはシステムの問題点を効率的に発見し、改善することができるでしょう。Grad-CAMによる判断過程の可視化は、自動運転システムの安全性を担保し、社会からの信頼を獲得する上で不可欠な技術と言えます。

Grad-CAMに関する最新の研究動向

Grad-CAMの登場以降、説明可能AIの分野では様々な改良手法が提案されています。ここでは、Grad-CAMの発展形であるGrad-CAM++やSmooth Grad-CAM++を紹介するとともに、説明可能AIの最新動向について解説します。

Grad-CAMの発展形であるGrad-CAM++やスムーズGrad-CAMなどの新手法を紹介

Grad-CAM++は、Grad-CAMの拡張版であり、ピクセル単位の重要度を求める方法を改良したものです。Grad-CAMでは、勾配の平均値を用いて重要度を計算していましたが、Grad-CAM++では勾配の二乗値を用いることで、より詳細で正確な重要度マップを生成します。これにより、物体の輪郭をより鮮明に可視化することができます。

Smooth Grad-CAM++は、Grad-CAM++をさらに改良した手法です。入力画像にノイズを加えて複数回の予測を行い、その結果を平均化することで、ヒートマップの滑らかさと信頼性を向上させています。ノイズの影響を軽減することで、よりロバストで解釈性の高い可視化結果が得られます。

これらのGrad-CAMの発展形は、AIの判断根拠をより詳細かつ正確に可視化することを可能にします。医療画像診断や自動運転など、高い信頼性が求められる分野での応用が期待されています。

説明可能なAIの実現に向けた、Grad-CAMを超える可視化技術の研究動向

説明可能AIの分野では、Grad-CAMを超える新しい手法の研究も進められています。Layer-wise Relevance Propagation(LRP)は、ニューラルネットワークの各層における関連性を伝播させることで、ピクセル単位の重要度を求める手法です。LRPは、Grad-CAMよりも詳細で正確な可視化結果を生成できることが報告されています。

また、Concept Activation Vectors(CAV)は、ニューラルネットワークが学習した概念を可視化する手法です。CAVを用いることで、「縞模様」や「毛むくじゃら」といった高レベルの概念が、画像のどの部分に存在するかを可視化することができます。これにより、AIが画像をどのように理解しているかをより直感的に把握することが可能になります。

さらに、説明可能AIの研究は、画像認識以外の分野にも広がりを見せています。自然言語処理や音声認識、強化学習など、様々なタスクにおいてAIの判断根拠を説明する試みが行われています。

これらの最新手法は、説明可能AIの可能性を大きく広げるものであり、今後のさらなる発展が期待されています。AIの判断プロセスを人間が理解・解釈できるようにすることは、AIの社会実装を進める上で不可欠な要素です。Grad-CAMに代表される可視化技術の進歩は、AIに対する信頼性を高め、人間とAIの協調を促進するでしょう。

Grad-CAMの課題と今後の展望

Grad-CAMは画期的な可視化手法ですが、いくつかの課題や問題点も指摘されています。ここでは、Grad-CAMの課題を整理し、説明可能AIの今後の展望について議論します。

Grad-CAMによる説明の解釈には注意が必要で、過剰な信頼は禁物

Grad-CAMが示す「重要な領域」は、必ずしも物体の検出結果を示すものではありません。あくまで、画像の中でどの部分が判断に影響を与えたかを示しているだけです。そのため、ヒートマップの解釈には注意が必要です。例えば、「重要な領域」が必ずしも物体の輪郭と一致しない場合があります。また、背景の一部が強調されることもあります。

このように、Grad-CAMの結果を過剰に信頼することは危険です。Grad-CAMはあくまで、AIの判断根拠を「可視化」するための手法であり、完全な「説明」を提供するものではありません。Grad-CAMの結果を参考にしつつも、人間の知識や経験に基づいて総合的に判断することが重要です。

AIの説明性と人間の納得性のバランスを取る必要性

説明可能AIの究極的な目標は、人間が納得できる説明を提供することです。しかし、AIの判断根拠を「説明」することと、人間がその説明を「納得」することは、必ずしも一致しません。機械学習モデルの複雑さゆえに、人間にとって直感的で理解しやすい説明を生成することは容易ではないのです。

また、説明可能性を追求するあまり、機械学習モデルの性能が犠牲になってしまうことも問題です。説明可能性と性能のバランスをどのように取るかは、重要な研究課題と言えます。

これらの課題を解決するためには、技術的なアプローチだけでなく、人文・社会科学の知見を取り入れることが不可欠です。人間の認知特性や社会的な価値観を考慮しながら、説明可能AIの研究を進めていく必要があるでしょう。

今後、Grad-CAMがAIの社会実装を促進し、人間とAIの協調を後押しすることへの期待

説明可能AIは、AIの社会実装を進める上で不可欠な要素です。AIの判断根拠を説明できるようにすることで、AIに対する社会的な信頼を醸成することができます。これは、医療や金融、自動運転など、AIの導入が期待される様々な分野において重要な意味を持ちます。

Grad-CAMは、説明可能AIの実現に向けた重要な一歩を担っています。今後、Grad-CAMをはじめとする可視化技術がさらに発展することで、AIの判断プロセスがより透明になることが期待されます。

同時に、説明可能AIの研究は、人間とAIが協調する未来の実現にも寄与すると考えられます。AIの判断根拠を人間が理解・解釈できるようになることで、人間とAIが互いの長所を活かし合いながら、様々な課題に取り組むことができるようになるでしょう。

Grad-CAMに代表される説明可能AIの技術は、まだ発展途上の段階にあります。課題の解決に向けた研究の進展と、社会的な議論の深化が求められています。しかし、その先に見据えるのは、AIと人間が協調し、より良い社会を作っていく未来です。Grad-CAMはその実現に向けた、重要な一歩となることが期待されています。